Żyjemy już w świecie, w którym wirtualni asystenci mogą prowadzić płynną (a nawet zalotną) rozmowę z ludźmi. Ale wirtualna asystentka Apple, Siri, ma problemy z niektórymi podstawami.

Na przykład zapytałem Siri, kiedy w tym roku odbędą się igrzyska olimpijskie, a ona szybko wypluła prawidłowe daty letnich igrzysk. Kiedy jednak odpowiedziałem: „Dodaj to do mojego kalendarza”, wirtualny asystent odpowiedział niedokładnie: „Jak mam to nazwać?”. Odpowiedź na to pytanie byłaby dla nas, ludzi, oczywista. Wirtualny asystent Apple zaginął. Nawet gdy odpowiedziałem: „Olimpiady”, Siri odpowiedziała: „Kiedy mam to zaplanować?”

Siri ma tendencję do słabnięcia, ponieważ brakuje jej świadomości kontekstowej, co ogranicza jej zdolność do podążania za rozmową jak człowiek. To może się zmienić już 10 czerwca, pierwszego dnia corocznej konferencji Apple Worldwide Developers Conference (WWDC). Oczekuje się, że producent iPhone’a zaprezentuje główne aktualizacje swojego nadchodzącego mobilnego systemu operacyjnego, który prawdopodobnie będzie nosił nazwę iOS 18, a według doniesień Siri przyniesie znaczące zmiany.

Wirtualny asystent Apple zrobił furorę, gdy zadebiutował w 2011 roku wraz z iPhonem 4S. Po raz pierwszy ludzie mogli rozmawiać ze swoimi telefonami i otrzymywać ludzką odpowiedź. Niektóre telefony z Androidem oferowały podstawowe wyszukiwanie głosowe i akcje głosowe przed Siri, ale były one bardziej oparte na poleceniach i powszechnie uważane za mniej intuicyjne.

Siri stanowiła krok naprzód w interakcji głosowej i położyła podwaliny pod kolejnych asystentów głosowych, takich jak Alexa firmy Amazon, Asystent Google, a nawet ChatGPT firmy OpenAI i chatboty Gemini firmy Google.

Przesuń się Siri, asystenci multimodalni są tutaj

Choć w 2011 roku Siri zaimponowała ludziom swoim doświadczeniem opartym na głosie, jej możliwości są tak widziane przez niektórych jako pozostający w tyle za swoimi rówieśnikami. Alexa i Asystent Google doskonale rozumieją pytania i odpowiadają na nie, a oba rozwinęły się w inteligentne domy na różne sposoby niż Siri. Wygląda na to, że Siri nie wykorzystała w pełni swojego potencjału – choć jej rywale spotkali się z podobną krytyką.

W 2024 r. Siri stanie także w obliczu radykalnie odmiennego krajobrazu konkurencyjnego, który został wzmocniony przez generatywną sztuczną inteligencję. W ostatnich tygodniach OpenAI, Google i Microsoft zaprezentowały nową falę futurystycznych wirtualnych asystentów z możliwościami multimodalnymi, które stanowią zagrożenie dla konkurencji dla Siri. Według profesora NYU Scotta Galloway’a na temat: najnowszy odcinek jego podcastute zaktualizowane chatboty mogą stać się „zabójcami Alexy i Siri”.

Scarlett Johannson i Joquin Phoenix byli na premierze Her na festiwalu filmowym w 2013 roku. Przenieśmy się do roku 2024, a Johannson oskarżył OpenAI o powielanie jej głosu w chatbocie bez jej zgody.

Na początku tego miesiąca OpenAI zaprezentowało swój najnowszy model sztucznej inteligencji. Ogłoszenie podkreśliło, jak daleko zaszli wirtualni asystenci. W swojej wersji demonstracyjnej w San Francisco OpenAI pokazało, jak GPT-4o może prowadzić dwustronne rozmowy w jeszcze bardziej ludzki sposób, łącznie z możliwością zmiany tonu, robienia sarkastycznych uwag, mówienia szeptem, a nawet flirtowania. Demodowana technologia szybko porównała postać Scarlett Johansson z filmu Hollywoodzki dramat Ona z 2013 roku, w którym samotny pisarz zakochuje się w swojej wirtualnej asystentce o kobiecym głosie, której podkłada głos Johansson. Po demie GPT-4o amerykańska aktorka oskarżyła OpenAI o stworzenie bez jej zgody głosu wirtualnej asystentki, który brzmiał „niesamowicie podobnie” do jej własnego. Open AI stwierdziło, że głos nigdy nie miał przypominać głosu Johanssona.

Kontrowersje najwyraźniej przyćmiły niektóre funkcje GPT-4o, takie jak natywne możliwości multimodalne, co oznacza, że model sztucznej inteligencji może rozumieć i reagować na dane wejściowe wykraczające poza tekst, obejmujące obrazy, język mówiony, a nawet wideo. W praktyce GPT-4o może porozmawiać z Tobą na temat pokazanego przez Ciebie zdjęcia (poprzez przesłanie multimediów), opisać, co dzieje się w klipie wideo i omówić artykuł prasowy.

Czytaj więcej: Scarlett Johansson „rozgniewana” z powodu chatbota OpenAI naśladującego „jej” głos

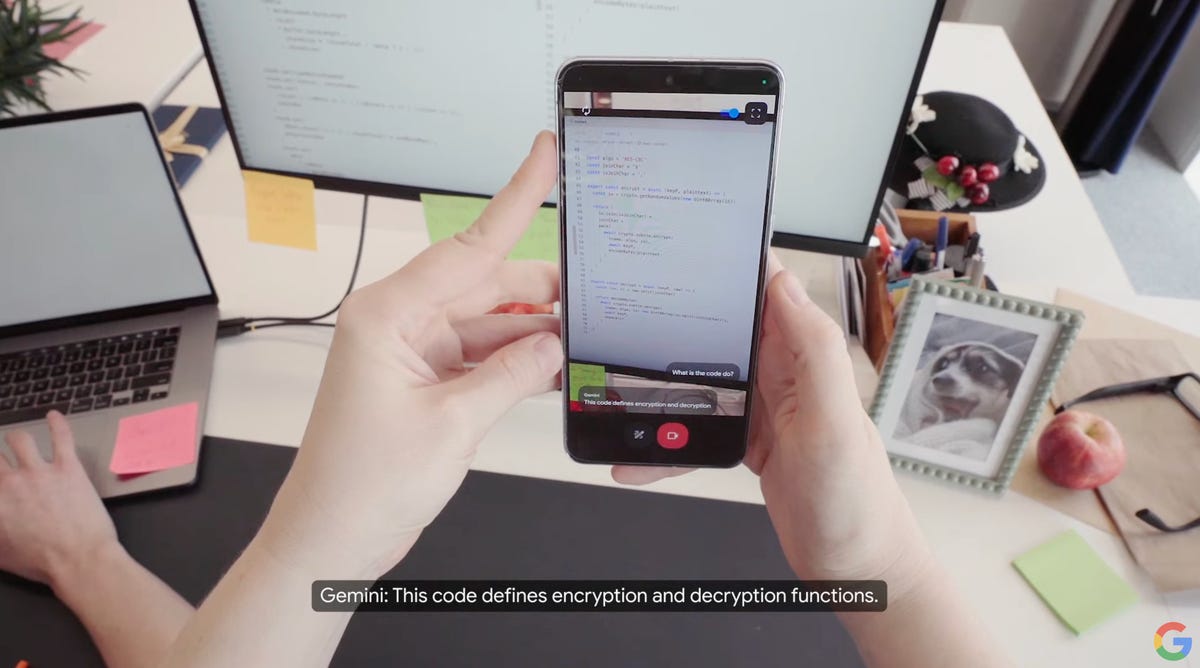

Dzień po premierze OpenAI Google zaprezentowało własne multimodalne demo, przedstawiając Projekt Astra — prototyp, który firma określiła jako „przyszłość asystentów AI”. W filmie demonstracyjnym Google szczegółowo opisał, jak użytkownicy mogą pokazać wirtualnemu asystentowi Google swoje otoczenie za pomocą aparatu w smartfonie, a następnie przystąpić do omawiania obiektów w swoim otoczeniu. Na przykład osoba wchodząca w interakcję z Atrą w prawdopodobnie londyńskim biurze Google poprosiła wirtualnego asystenta Google o zidentyfikowanie obiektu, który wydaje dźwięk w pomieszczeniu. W odpowiedzi Astra wskazała mówcę siedzącego na biurku.

Google zademonstrował Astrę na telefonie, a także na okularach z obsługą aparatu.

Prototyp Astry Google’a nie tylko potrafi zrozumieć otoczenie, ale także zapamiętuje szczegóły. Kiedy narrator zapytał, gdzie zostawili okulary, Astra była w stanie powiedzieć, gdzie byli ostatnio widziani, odpowiadając: „W rogu biurka obok czerwonego jabłka”.

Wyścig w tworzeniu efektownych wirtualnych asystentów nie kończy się na OpenAI i Google. Według nich firma Elona Muska zajmująca się sztuczną inteligencją, xAI, czyni postępy w przekształcaniu chatbota Grok w takiego, który ma możliwości multimodalne publiczne dokumenty deweloperskie. W maju Amazon poinformował, że pracuje nad udostępnieniem Alexie, swojej wieloletniej wirtualnej asystentce, generatywnej aktualizacji sztucznej inteligencji.

Czy Siri stanie się multimodalna?

Multimodalne chatboty konwersacyjne stanowią obecnie najnowocześniejsze rozwiązanie dla asystentów AI, potencjalnie oferując wgląd w przyszłość tego, jak poruszamy się po naszych telefonach i innych urządzeniach.

Apple nie ma jeszcze cyfrowego asystenta z funkcjami multimodalnymi, co stawia go w tyle. Producent iPhone’a opublikował jednak badania na ten temat. W październiku omówiono Fretka, multimodalny model sztucznej inteligencji, który potrafi zrozumieć, co dzieje się na ekranie Twojego telefonu i wykonywać szereg zadań na podstawie tego, co widzi. w papierbadacze badają, między innymi, w jaki sposób Ferret może identyfikować i raportować na temat tego, na co patrzysz, a także pomagać Ci w poruszaniu się po aplikacjach. Badanie wskazuje na możliwą przyszłość, w której całkowicie zmieni się sposób, w jaki korzystamy z iPhone’ów i innych urządzeń.

Apple bada funkcjonalność multimodalnego asystenta AI o nazwie Ferret. W tym przykładzie asystent pomaga użytkownikowi poruszać się po aplikacji, przy czym Ferret wykonuje podstawowe zadania i zaawansowane, takie jak szczegółowy opis ekranu.

Apple może się wyróżnić pod względem prywatności. Producent iPhone’a od dawna opowiada się za prywatnością jako podstawową wartością przy projektowaniu produktów i usług, dlatego będzie wystawiał nową wersję Siri jako bardziej prywatną alternatywę dla swoich konkurentów, według New York Timesa. Oczekuje się, że Apple osiągnie ten cel w zakresie ochrony prywatności, przetwarzając żądania Siri na urządzeniu i korzystając z bardziej złożonych zadań w chmurze, ale według „Wall Street Journal” zadania te będą przetwarzane w centrach danych z chipami wyprodukowanymi przez Apple raport.

Jeśli chodzi o chatbota, Apple jest blisko sfinalizowania umowy z OpenAI, która potencjalnie umożliwi wprowadzenie ChatGPT na iPhone’a, według Bloomberg, co może wskazywać, że Siri nie będzie bezpośrednio konkurować z ChatGPT ani Gemini. Zamiast robić takie rzeczy, jak pisanie wierszy, Siri skupi się na zadaniach, które już może wykonać, i będzie w nich lepsza, według New York Timesa.

W ramach demonstracji WWDC 2012 Scott Forstall, starszy wiceprezes Apple ds. oprogramowania dla systemu iOS, poprosił Siri o sprawdzenie średniej liczby uderzeń baseballisty.

Jak zmieni się Siri? Wszystkie oczy zwrócone na WWDC firmy Apple

Tradycyjnie Apple celowo powoli wchodziło na rynek, preferując podejście wyczekujące w odniesieniu do pojawiających się technologii. Ta strategia często działała, ale nie zawsze. Na przykład iPad nie był pierwszym tabletem, ale dla wielu, w tym redaktorów CNET, jest najlepszym tabletem. Z drugiej strony inteligentny głośnik Apple HomePod pojawił się na rynku kilka lat po Amazon Echo i Google Home, ale nigdy nie dogonił udziału w rynku konkurentów. Nowszym przykładem po stronie sprzętu są telefony składane. Jedynym poważnym przeciwnikiem jest Apple. Każdy większy rywal – Google, Samsung, Honor, Huawei, a nawet mniej znane firmy, takie jak Phantom – pobił Apple.

Historycznie rzecz biorąc, Apple stosował podejście polegające na okresowym aktualizowaniu Siri, mówi Avi Greengart, główny analityk w Techsponential.

„Apple zawsze bardziej programowo podchodziło do Siri niż Amazon, Google czy nawet Samsung” – powiedział Greengart. Wygląda na to, że Apple masowo dodaje wiedzę do Siri – w jednym roku sport, w następnym rozrywkę.”

Powszechnie oczekuje się, że w tym roku Apple będzie raczej nadrabiać zaległości, niż wprowadzać nowe rozwiązania w przypadku Siri. Mimo to Siri będzie prawdopodobnie głównym tematem nadchodzącego systemu operacyjnego Apple, iOS 18, który podobno wprowadzi nowe funkcje sztucznej inteligencji. Oczekuje się, że Apple zaprezentuje dalsze integracje sztucznej inteligencji z istniejącymi aplikacjami i funkcjami, w tym Notatkami, emoji, edycją zdjęć, wiadomościami i e-mailami, według Bloomberga.

Siri może odpowiadać na pytania dotyczące zdrowia na Apple Watch Series 9 i Ultra 2.

Jeśli chodzi o Siri, przewiduje się, że w tym roku przekształci się ona w bardziej inteligentnego cyfrowego pomocnika. Apple podobno szkoli swojego asystenta głosowego w zakresie dużych modeli językowych, aby poprawić jego zdolność do odpowiadania na pytania z większą dokładnością i wyrafinowaniem, według październikowe wydanie biuletynu Bloomberga Marka Gurmana Power On.

Integracja dużych modeli językowych, a także technologia stojąca za ChatGPT, może przekształcić Siri w bardziej kontekstowego i wydajnego wirtualnego asystenta. Umożliwiłoby to Siri zrozumienie bardziej złożonych i bardziej szczegółowych pytań, a także zapewnienie dokładnych odpowiedzi. Oczekuje się, że tegoroczna linia iPhone’ów 16 będzie również wyposażona w większą pamięć obsługującą nowe funkcje Siri, według New York Timesa.

Czytaj więcej: Co to jest LLM i jaki ma związek z chatbotami AI?

„Mam nadzieję, że Apple będzie w stanie wykorzystać generatywną sztuczną inteligencję, aby Siri mogła poczuć się bardziej jak przemyślany asystent, który rozumie, o co próbujesz zapytać, ale jednocześnie będzie używać systemów opartych na danych do udzielania odpowiedzi powiązanych z danymi” – powiedział CNET Greengart z Techsponential.

Siri mogłaby również ulepszyć wykonywanie zadań wieloetapowych. Wrzesień raport w The Information szczegółowo opisano, w jaki sposób Siri może reagować na proste polecenia głosowe w przypadku bardziej złożonych zadań, takich jak przekształcanie zestawu zdjęć w plik GIF, a następnie wysyłanie go do jednego z kontaktów. Byłby to znaczący krok naprzód w możliwościach Siri.

„Apple definiuje także sposób działania aplikacji na iPhone’a, dlatego może pozwolić Siri na pracę między aplikacjami za zgodą programisty, co potencjalnie otwiera nowe możliwości dla inteligentniejszej Siri, która może bezpiecznie wykonywać zadania w Twoim imieniu” – powiedział Greengart.

Patrz na to: Sztuczna inteligencja Apple na WWDC przyjmie inny obrót

17 ukrytych funkcji iOS 17, o których zdecydowanie powinieneś wiedzieć

Zobacz wszystkie zdjęcia

Uwaga redaktora: CNET wykorzystał silnik AI do stworzenia kilkudziesięciu historii, które zostały odpowiednio oznaczone. Notatka, którą czytasz, jest dołączona do artykułów, które merytorycznie dotyczą tematu sztucznej inteligencji, ale zostały stworzone w całości przez naszych doświadczonych redaktorów i autorów. Więcej informacji znajdziesz w naszym Polityka sztucznej inteligencji.